python爬虫教程xpath模拟登陆,python 模拟登录

作者:admin 发布时间:2024-04-14 15:45 分类:资讯 浏览:21 评论:0

如何使用python爬虫如何爬取米思米案例库?请大神来帮忙1

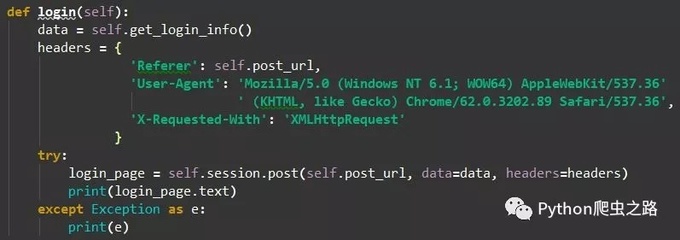

背景:首先对于登录页面,你作为普通人类,是怎么需要输入账号和密码,才能登录后,查看到页面的。用selenium:那么就是让selenium去定位到对应的账号输入框和密码输入框,分别输入账号和密码,再定位到登录按钮,点击登录。

安装必要的库 为了编写爬虫,你需要安装一些Python库,例如requests、BeautifulSoup和lxml等。你可以使用pip install命令来安装这些库。抓取网页数据 主要通过requests库发送HTTP请求,获取网页响应的HTML内容。

使用Python编写网络爬虫程序的一般步骤如下: 导入所需的库:使用import语句导入所需的库,如BeautifulSoup、Scrapy和Requests等。 发送HTTP请求:使用Requests库发送HTTP请求,获取网页的HTML源代码。

以下是使用Python编写爬虫获取网页数据的一般步骤: 安装Python和所需的第三方库。可以使用pip命令来安装第三方库,如pip install beautifulsoup4。 导入所需的库。例如,使用import语句导入BeautifulSoup库。

方法/步骤 在做爬取数据之前,你需要下载安装两个东西,一个是urllib,另外一个是python-docx。

我们创建一个爬虫,递归地遍历每个网站,只收集那些网站页面上的数据。

python怎么爬取数据

python爬虫,需要安装必要的库、抓取网页数据、解析HTML、存储数据、循环抓取。安装必要的库 为了编写爬虫,你需要安装一些Python库,例如requests、BeautifulSoup和lxml等。你可以使用pip install命令来安装这些库。

以下是使用Python3进行新闻网站爬取的一般步骤: 导入所需的库,如requests、BeautifulSoup等。 使用requests库发送HTTP请求,获取新闻网站的HTML源代码。 使用BeautifulSoup库解析HTML源代码,提取所需的新闻数据。

用python爬取网站数据方法步骤如下:首先要明确想要爬取的目标。对于网页源信息的爬取首先要获取url,然后定位的目标内容。先使用基础for循环生成的url信息。

那么,我们如何做到从PDF中爬取表格数据呢??答案是Python的camelot模块!?camelot是Python的一个模块,它能够让任何人轻松地从PDF文件中提取表格数据。

python爬虫的工作步骤

1、我们可以通过python 来实现这样一个简单的爬虫功能,把我们想要的代码爬取到本地。下面就看看如何使用python来实现这样一个功能。具体步骤 获取整个页面数据首先我们可以先获取要下载图片的整个页面信息。

2、这个信息收集分析整合的工作,可应用的范畴非常的广泛,无论是生活服务、出行旅行、金融投资、各类制造业的产品市场需求等等……都能够借助这个技术获取更精准有效的信息加以利用。

3、是加密的,解密方法在JS里面可以弄出来。首先要AES解密,可以【Python:import Crypto.Cipher.AES】包,解密mode是CFB,seed是userId:+uid+:seed的SHA256值,解密的key是seed[0:24],iv是seed[len(seed)-16:]。

4、Python网络爬虫是使用Python编写的一种网络数据采集工具。Python提供了丰富的库和模块,使得编写网络爬虫变得简单和高效。通过编写Python程序,可以模拟人类在浏览器中访问网页的行为,自动抓取网页上的数据。

5、爬虫一般是指网络资源的抓取,由于Python的脚本特性,易于配置对字符的处理非常灵活,Python有丰富的网络抓取模块,因此两者经常联系在一起Python就被叫作爬虫。

一周搞定Python爬虫,网络爬虫实战第三天-猫眼测试xpath的写法_百度知...

为自动提取网页的程序,它为搜索引擎从万维网上下载网页。网络爬虫为一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成。

需要使用各种技术和工具来实现,如正则表达式、XPath、BeautifulSoup等。同时,网络爬虫技术也面临着一些挑战和限制,如反爬虫机制、网站访问限制等。因此,在使用网络爬虫技术时需要遵守相关法律法规和道德规范,确保合法合规。

本程序由Python写成,所以基本的python知识是必须的。另外,如果你有一定的计算机网络基础,在前期准备时会有少走很多弯路。

《精通Python爬虫框架Scrapy》以Scrapy 0版本为基础,讲解了Scrapy的基础知识,以及如何使用Python和三方API提取、整理数据,以满足自己的需求。

你输出html看看,根本不是网页。这网站好像有反爬限制。你用基于浏览器的爬虫试试。例如 chrome 的 Web Scraper。

python爬虫项目实战:爬取糗事百科用户的所有信息,包括用户名、性别、年龄、内容等等。

相关推荐

欢迎 你 发表评论:

- 资讯排行

- 标签列表

- 友情链接